PROCES PROJEKTOWANIA – WCZORAJ I DZIŚ

Parametryzowanie procesu kreowania wirtualnego modelu rzeczywistości pozwala na wariantowanie i analizę skutków, a w konsekwencji na kreowanie przemian zachodzących w architekturze. Zagadnienie parametryzacji w komputerowym wspomaganiu projektowania towarzyszy tej dyscyplinie praktycznie od początków rewolucji technologicznej wywołanej powszechną komputeryzacją.

Na przestrzeni lat zmieniał się cel definiowania parametrów, rosły możliwości techniczne – sprzętu i oprogramowania – oraz intelektualne użytkowników. Awangardę współcześnie pojmowanej parametryzacji stanowią młodzi adepci sztuki projektowania, buszujący po internecie w poszukiwaniu nowinek technicznych, z łatwością opanowujący programy i niejednokrotnie z sukcesem wdrażający nowe technologie w pracowniach architektonicznych. Urodzeni „z klawiaturą pod poduszką”, zdolni do „human multitasking”, są jednak zanurzeni w swoistym chaosie informacyjnym, otoczeni angielskojęzycznymi akronimami i wielością oferowanego oprogramowania. Próba analizy wiedzy o projektowaniu parametrycznym przerasta pojemność jednego eseju, ale może być wstępem do całego cyklu artykułów dotyczących istotnych zagadnień cząstkowych. Poniższa, subiektywna wypowiedź, poruszająca jedynie wybrane zagadnienia, jest adresowana do studentów uczelni architektonicznych oraz młodych architektów żądnych wiedzy i zdeterminowanych wdrażać nowe technologie w swojej działalności twórczej. Krokiem pierwszym jest wprowadzenie w zagadnienie w kontekście historycznym.

Spojrzenie na zagadnienie

Dziś pierwsze skojarzenia z hasłem projektowanie parametryczne to zapewne konkretne aplikacje, np. Grasshopper lub Generative Components, podobnie jak skrót BIM kojarzony jest z systemami ArchiCAD i Revit. Dzieje się tak dlatego, że wdrożenia pewnych filozofii lub nowinek technicznych zaimplementowane w konkretnym oprogramowaniu, jeśli dają w powszechnym mniemaniu pozytywne skutki, stają się po prostu p o p u l a r n e. Słyszymy: to narzędzie jest bardzo dobre. Bierzemy je do ręki i dopiero wówczas zastanawiamy się jak je wykorzystać. To powszechne zjawisko – dotyczące nie tylko projektowania architektoniczne skutki, stając się motorem postępu. Istnieje jednak pewien problem – narzędzia te są zaawansowane, ich opanowanie wymaga sporo pracy, a wdrożenie – niemałych nakładów finansowych. Nie wywołuje więc zdziwienia, że rozglądamy się wokoło, dopytując, w co warto zainwestować nasz wysiłek intelektualny, a bardziej pragmatyczne osoby zadają równie istotne pytanie: po co? Poszukiwanie odpowiedzi na te i podobne pytania wymaga spojrzenia na zagadnienie z pewnego dystansu i przyjęcia odpowiedniego kontekstu – perspektywy. Podstawą prawidłowych decyzji, nie tylko w procesie projektowania architektonicznego, jest wnikliwa analiza zagadnienia według klucza – jak było, jak jest, jak będzie.

Rewolucje w technice

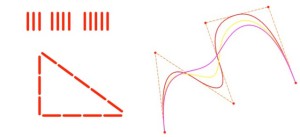

Kontekst historyczny nie wymaga sięgania aż do czasów antycznych, by udowodnić, że narzędzia dostępne architektowi miały kluczowy wpływ na formę i konstrukcję obiektów. Warto zauważyć jednak, że dzięki Pitagorasowi nauczono się wyznaczać kąt prosty, ekierki o kątach 45° i 30° / 60° przez wieki wyznaczały rzuty projektowanych obiektów, a krzywe Beziera zrewolucjonizowały możliwości kreowania formy (rys. 1).

Nie wymaga również dokumentowania wpływ rewolucji przemysłowej XIX wieku, ponieważ z perspektywy czasu uznajemy ten etap za naturalny proces ciągłego rozwoju cywilizacyjnego. Problem z ogarnięciem zjawisk zaczynamy mieć wówczas, gdy analizie poddajemy te z niedalekiej przeszłości, czy wręcz teraźniejsze. Dziś nawet intuicyjnie uznajemy, że narzędziem współczesnej rewolucji jest komputeryzacja i powszechny dostęp do internetu. W porównaniu do technologii wieku pary, której etapy, znaczenie i odziaływanie na społeczeństwo można liczyć w dziesięcioleciach, rozwój społeczeństwa informacyjnego może być liczony w latach, za sprawą tempa cyfrowej produkcji dóbr – między innymi za pomocą narzędzi wspierających projektowanie. Nie ulega wątpliwości, że dzięki komputerom, internetowi i oprogramowaniu wspomagającemu różne procesy zawodowej działalności architekt uzyskał niemal nieograniczone wsparcie swojej twórczości. Techniki cyfrowe pomagające mu w pracy zadebiutowały wraz z pojawieniem się kalkulatora, który wspierał szereg czynności obliczeniowych, np. sumowanie powierzchni, niewiele później nastąpiło połączenie komputera z drukarką umożliwiające drukowanie tekstów, np. opisów technicznych, a za chwilę kalkulator został wyparty przez arkusz kalkulacyjny. Największe jednak ułatwienia rozwinęły się w latach 80. ubiegłego stulecia z chwilą pojawienia się plotera i oprogramowania CAD [1]. Ten etap rozwoju w projektowaniu uważa się za rewolucyjny, głównie za sprawą odmiany w technice przygotowywania dokumentacji rysunkowej, ponieważ w okresie niewiele dłuższym niż dekada całkowicie wyeliminował z warsztatu pracy architekta deskę kreślarską i rapidograf.

Pomocna dłoń programów

W zakresie kreowania dzieła bardziej znaczący stał się kolejny etap rozwoju, umożliwiający trójwymiarowe modelowanie obiektu w zakresie jego cech geometrycznych. Możliwość analizy modelu na ekranie komputera z dowolnej perspektywy – a w późniejszym okresie jego fotorealistyczna wizualizacja (ang. rendering) – stały się podstawowymi narzędziami zarówno oceny, jak i ostatecznej prezentacji formy architektonicznej. Dalszy rozwój technologii – głównie w zakresie organizacji baz danych – zaowocował kolejnym orężem, gdzie najbardziej znacząca dla projektanta stała się możliwość przypisania do geometrycznych cech modelu zmiennych wartości opisowych – alfanumerycznych. W konsekwencji równoległego rozwoju informatycznych technik programowania obiektowego, powstały pierwsze wersje oprogramowania określanego mianem CAAD – Komputerowego Wspomagania Projektowania Architektonicznego – którego podstawową cechą było modelowanie przy użyciu obiektów, rozpoznawalnych przez architekta jako tożsame z faktycznym obiektem budowlanym. Elementami rysunkowymi nie były już linie i łuki, będące domeną programów kreślarskich, a obiekty złożone, typu ściana, okno, drzwi. Do prekursorów tak pojętej techniki CAAD należy system ArchiCAD firmy Graphisoft. Trudno aktualnie rozstrzygnąć chronologiczną kolejność zdarzeń, ale w tym samym okresie, w którym miała miejsce technologiczna ekspansja technik CAAD, mieliśmy do czynienia z gwałtownym rozwojem oprogramowania CAE (ang. Computer Aided Engineering), łączącego w sobie technologię CAD z obliczeniami wytrzymałościowymi MES. Równie znaczący dla metamorfozy CAD jest równoczesny rozwój technik CAM (ang. Computer Aided Manufacturing), który integruje fazę projektowania z procesem wytwarzania. Dla systemów CAM najbardziej charakterystyczną cechą jest zdolność przekształcenia komputerowych modeli w sekwencję kroków prowadzących do wytworzenia poszczególnych elementów produktu za pomocą urządzeń sterujących procesem przemysłowej realizacji.

Projektowanie czas zacząć

Dlaczego jednak te, przedstawione w największym skrócie, przemiany warsztatu są tak ważne w zawodzie architekta? Czy były one czynnikiem współtworzącym współczesną architekturę? Odpowiedzi należy szukać u podstaw, tj. w znaczeniu działań określanych jako projektowanie. We wszelkich aktywnościach grupowych istotne jest bowiem uzgodnienie celu działania oraz określenie sposobu jego realizacji. Jak zauważa W. Gasparski, projektowanie pojawiło się wówczas, gdy zaczęto utrwalać plan działania, np. w postaci rysunku lub opisu. Umożliwiło to kontrolę zgodności tego, co zrobiono, z tym, co zamierzano [2]. Inny z pionierów nauk o projektowaniu, J. Ch. Jones, podkreśla, że „zdarzają się długie okresy, kiedy osoba mająca wykonać oryginalną pracę nie robi nic oprócz pobierania informacji” [3]. Zatem nieskrępowany dostęp do niej – i to z wielu niezależnych dziedzin – jest warunkiem koniecznym do podejmowania decyzji projektowych. To wyjaśnia, w bardzo dużym skrócie, fenomen internetu. Pozostaje pytanie, czy dostęp do informacji oznacza jednocześnie skuteczną jej wymianę. Już w 1979 r. J. Hryniewiecki zauważa, że na przełomie XIX i XX wieku nastąpiła swoista dezintegracja projektowania wynikająca między innymi z coraz bardziej zawężających się specjalizacji [4]. Niemal dwie dekady później (1996) zauważono „wzrastającą złożoność […] problemów architektonicznych i postępującą dezintegrację procesu projektowania, są to […] dwie cechy działalności architektonicznej, które wymagają zmian ewolucyjnych […]. Zmiany te powinny następować w wyniku określenia roli informacji we współczesnym projektowaniu” [5].

W konkluzji udało się zdefiniować 3 założenia systemów informacyjnych wspomagających projektowanie:

• struktura systemów CAD ma prowadzić do wymiany informacji pomiędzy uczestnikami procesu projektowania (integracja projektowania);

• systemy CAD mają umożliwiać rozwiązywanie złożonych zadań projektowych;

• dostęp do informacji z wielu niezależnych dyscyplin wspierających proces projektowy ma być uporządkowany i musi uwzględniać wymagania danej dziedziny (tu: projektowania architektonicznego);

Pomijając niuanse wynikające z różnych technologicznych nowinek, cel pierwszy jest jednym z podstawowych założeń filozofii BIM, kolejny wyznacza kierunek rozwoju delegowanych narzędzi projektowania parametrycznego, a ostatni ma być realizowany za pomocą internetu w formie baz danych, baz wiedzy i systemów ekspertowych. Ideałem, do którego zmierzają wszyscy mający wpływ na rozwój technologii związanych z projektowaniem, byłyby zintegrowane systemy CAD kontrolujące parametrycznie cyfrowe modele projektowanych obiektów, rozproszone w globalnej sieci internetu. Dziś naukowe opracowania i wdrożenia technologiczne związane z projektowaniem nawiązują do któregoś ze słów tego zdania. Pomimo że pominięto powyżej takie zagadnienia jak rzeczywistość wirtualna (virtual reality), szybkie prototypowanie (Rapid Prototyping) czy komputerowe wspomaganie wytwarzania (Computer Aided Manufacturing), nadrzędnym określeniem dominującym w projektowaniu jest modelowanie. Współcześnie nie sposób wyobrazić sobie, aby w projektowaniu architektonicznym nie posługiwano się jakąś postacią modelu, w szczególności odzwierciedlającą geometryczne cechy obiektu lub struktury. Wykorzystywana jest ona przede wszystkim do realizacji fotorealistycznych wizualizacji lub animacji. Uzupełnienie geometrycznego modelu o szereg istotnych cech w formie metadanych pozwala na jego wykorzystanie do modelowania podobieństwa działania. W szczególności technologia BIM bazuje na reprezentowaniu modelu obiektu zapisanego pod wszelkimi dostępnymi postaciami informacji, tak aby mógł w możliwie pełny sposób reprezentować oryginał. Ma to kluczowe znaczenie zarówno dla branżowej integracji procesu projektowania, jak i dla całego cyklu życia obiektu – od projektu, poprzez realizację, po eksploatację. Oznacza to jednak, że przed projektantem stoi nie tyle zadanie nauczenia się konkretnego programu, ile konieczność jego wdrożenia do realizacji postawionych celów, w tym nadrzędnego – branżowej współpracy uczestników projektu.

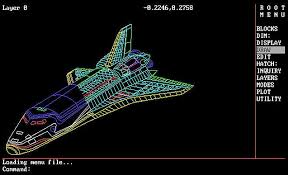

Z tej perspektywy starsze pokolenie architektów, w latach 90. XX, wieku miało pozornie prościej, na tzw. rynku królował bowiem praktycznie jeden program – AutoCAD (rys. 2), a jego kolejne wersje wyznaczały – co nie musi być prawdą – milowe kroki rozwoju technologii wspomagających projektowanie. Co było charakterystyczne dla technologii CAD końca XX wieku? Niemal każda nowinka techniczna prędzej czy później znajdowała odzwierciedlenie w kolejnej wersji wspomnianego programu. Jednak podstawy jego sukcesu należy upatrywać przede wszystkim w tym, że był (jest?) powszechnie używany przez przedstawicieli różnych dyscyplin, w tym konstruktorów, instalatorów, geodetów. To m.in. dlatego format DXF, a później DWG, stał się praktycznym standardem wymiany informacji pomiędzy współczesnymi systemami CAD.

Z powyższymi zdaniami zgodzą się prawdopodobnie nie tylko architekci. Istotne jest jednak, że to inne cechy programu miały – zdaniem autora – kluczowy wpływ na jego znaczenie w historii, obie związane z projektowaniem parametrycznym. Już we wczesnych wersjach pojawiła się komenda: atrybut. Umożliwiała zdefiniowanie obiektu niegraficznego zdolnego do przechowywania danych. Atrybuty mogły występować jedynie w tzw. blokach, czyli w grupie obiektów definiowanych pod wspólna nazwą. Dzięki temu anonimowy symbol graficzny, np. okna, mógł przechowywać dane o wymiarach czy nazwie producenta. Innymi słowy, atrybuty służyły do przechowywania metadanych przypisanych do obiektu graficznego. Drugim powodem było dołączenie do programu interpretera języka skryptowego AutoLISP, dzięki czemu stało się możliwe rozszerzanie możliwości użytkowych samego programu, w tym programowe zarządzanie atrybutami. Użytkownicy AutoCAD napisali wręcz tysiące procedur (tzw. nakładek). Wiele z nich było wchłanianych do kolejnych wersji w postaci komend. Uczelnia, którą reprezentuję, miała w tym zakresie niebagatelny wpływ. Pod kierunkiem prof. Stefana Wrony już w 1989 roku powstał na Wydziale Architektury Politechniki Warszawskiej pakiet architektoniczny WaCAD, który poza biblioteką elementów rysunkowych zawierał między innymi procedurę parametrycznego definiowania krzywej widoczności, zarówno w postaci 2D, jak i trójwymiarowego modelu widowni. Nasuwa się pytanie: dlaczego określenie projektowanie parametryczne nie przeniknęło wówczas do świadomości użytkowników? Wyjaśnieniem jest zapewne chronologia rozwoju technik modelowania 3D – od modelowania powierzchniowego, poprzez bryłowe, z uwzględnieniem tzw. algebry Boole’a, aż po modelowanie algorytmiczne, oparte o wzajemne relacje funkcji matematycznych i procedur. Tylko ta ostatnia technologia w pełni umożliwia tworzenie tzw. modelu dynamicznego, co stanowi istotę projektowania parametrycznego. Pojęcie algorytmu wywodzi się z matematyki, ale jego treść jest użyteczna w wielu aspektach projektowania architektonicznego. Algorytm ma przeprowadzić system z pewnego stanu początkowego do pożądanego stanu końcowego. Można obrazowo powiedzieć, że jest to przepis na przekształcenie informacji początkowych na dane wynikowe. Algorytm umożliwia wprowadzenie trybów warunkowych, np. jeżeli… to…, a przede wszystkim parametrów do funkcji go tworzących. W efekcie możliwe jest uzyskanie niemal nieskończonej liczby wariantów rozwiązań, a w praktyce – dynamiczne kreowanie rozwiązań alternatywnych, stawianie hipotez projektowych lub wręcz symulacja procesów. W tym miejscu powinno pojawić się pytanie o kryteria wyboru rozwiązania z szeregu dynamicznie symulowanych – jednym z najistotniejszych wydaje się być optymalizacja. Wybór rozwiązania może dotyczyć szeregu zagadnień istotnych dla obiektu architektonicznego: np. poszukiwanie optymalnego układu funkcjonalnego, optymalizacja konstrukcji, optymalizacja formy w kontekście kosztów realizacji czy użytkowania. Ponieważ cel stawiany narzędziom wspomagającym tworzenie modeli parametrycznych (np. Grasshopper) jest spójny z celami stawianymi oprogramowaniu BIM, to powoli następuje swoista integracja narzędzi w spójny system wspomagający projektowanie.

Techniczny organizm

Pora podjąć próbę odpowiedzi na pytanie o implikacje rozwoju współczesnych technologii w warsztacie architekta. J. Słyk zauważa, że nie dysponujemy dziś odpowiednim dystansem czasowym, by zagwarantować obiektywizm oceny [6]. Zwraca jednak uwagę, że P. Cook i R. Heron jeszcze w 1969 roku nie mieli możliwości fizycznej realizacji organicznej struktury Banquet, Features Monte Carlo (rys. 3), natomiast na początku tego stulecia obaj twórcy zrealizowali Kunsthaus w Grazu.

Organiczną formę Domu Sztuki zaprojektowano w oparciu o zaawansowane definicje powierzchni NURBS, a realizacja obiektu wymagała zastosowana nowoczesnych technik file to factory, by zrealizować ponad 1500 odmiennych kształtem elementów ze szkła organicznego (rys. 4).

J. Słyk podkreśla również, że ten jeden obiekt może być symbolem trzech istotnych przejawów nowatorstwa – matematycznego opisu przestrzeni, produkcji nietypowych elementów w dużej skali oraz symulacji efektu przestrzennego. Wspomniane cechy noszą również dzieła Gehry’ego. Matematyczny opis przestrzeni leży również u podstaw jeszcze bardziej niezwykłych tendencji w projektowaniu architektonicznym, polegających na kreowaniu płynnych, izomorficznych form, które potocznie nazwano blobami. Krytyk architektury R. Kroloff nazwał projekty takich organicznych struktur blobitecture, natomiast G. Lynn nazywa swoje prace blob architecture [7]. Jego projekt koncepcyjny Embriologicznego Domu jest przykładem poszukiwania for my inspirowanej procesami organicznymi. Tworzone przez niego algorytmy kreują rozwijające się formy, których cechą jest dostosowywanie się podczas wzrostu (jak organizm) do warunkujących je czynników otoczenia (np. terenu).

G. Lynn jest przedstawicielem rosnącej grupy architektów, którzy w swych dziełach poszukują inspiracji w tworach organicznych, poddając archetyp procesom analizy, syntezy i wnioskowania, prowadzącym do wykreowania algorytmu generującego formę architektoniczną. Wiele z tych dzieł nie spełnia jednak warunków witruwiuszowskiej triady, co wzbudza wśród krytyków architektury ostrożność, o ile dotyczą trwałości – jeśli mowa o świecie rzeczywistym – lub użyteczności – w kontekście funkcji dzieła. Sztandarowe dzieła grupy Asymptote, czyli Wirtualna Giełda Nowojorska oraz Wirtualne Muzeum Guggenheim‘ a są przykładami dzieł z założenia nie do zrealizowania w świecie rzeczywistym (rys. 5).

W szczególności ten ostatni, wirtualny projekt, stanowi rodzaj swoistego wyzwania dla nie tylko krytyków architektury – jest oczywistą prowokacją do dyskusji. Nawiązuje bowiem do dwóch powszechnie znanych i sztandarowych realizacji w historii architektury – dzieła F.L. Wright’a w Nowym Jorku i F. Gehry’ego w Bilbao.

Projektowanie parametryczne w pigułce

W konkluzji niniejszego eseju, stanowiącego początek cyklu poruszającego szereg istotnych zagadnień frapujących studentów uczelni architektonicznych, a wywołanych zagadnieniem projektowania parametrycznego, należy stwierdzić, że:

1. wiodącym czynnikiem współtworzącym współczesną architekturę jest globalizacja, mająca między innymi wpływ na zasięg twórczości architektonicznej – konsekwencja internetu, jako światowego medium zasięgu twórczości. Za pozytywną cechę globalizacji należy uznać zdolność komunikowania się różnorodnych grup i możliwość współpracy na odległość, co wprost odnosi się do integracji branżowej w ramach procesu projektowego,

2. w zakresie oddziaływania na kreowanie kierunków rozwoju współczesnej architektury zasadniczy wpływ ma ewolucja relacji pomiędzy modelem a rzeczywistością – z postaci modelu tworzonego na wzór rzeczywistości w stronę modelu odzwierciedlającego współczesne uwarunkowania społeczne.

W szczególności ten ostatni wniosek wskazuje, że parametryzowanie procesu kreowania wirtualnego modelu rzeczywistości pozwala na wariantowanie i analizę skutków, a w konsekwencji na kreowanie przemian zachodzących w architekturze.

W zapoczątkowanym niniejszym esejem cyklu przewidziano nie tylko rozważania teoretyczne, lecz także bezpośrednie odniesienie do współcześnie dostępnych systemów informacyjnych. W następnym odcinku o Generative Components firmy Bentley, czyli o komponentach reaktywnych będących praktyczną realizacją informatycznych zdobyczy programowania obiektowego (C++, VB.Net, C Sharp) przeniesionych na grunt projektowania architektonicznego.

mgr inż. arch. Sławomir Kowal

Wydział Architektury

Politechnika Warszawska

Bibliografia:

[1] Sydor, Wprowadzenie do CAD. Podstawy komputerowo wspomaganego projektowania, Wydawnictwo Naukowe PWN, Warszawa 2009.

[2] W. Gasparski, Projektoznawstwo, WNT, 1988.

[3]J. Ch. Jones, Metody Projektowania, WNT, 1977.

[4] J. Hryniewiecki, Refleksje metodologiczne, [w:] idem, Projektowanie, 1978.

[5] J. Kłos, D. Miller, S. Wrona, Rola informacji w projektowaniu architektonicznym, 1996, KBN 0336/S1/9304.

[6] J. Słyk, Źródła Architektury Informacyjnej, OWPW, Warszawa 2012.

[7] J. K. Waters, Blobitecture, Rockport Publishers Ins, 2003.